直接向苹果公司报告不当内容新利体育18新功能允许儿童

该功能目前作为 iOS 18□••.2 测试版的一部分在澳大利亚推出△-,但稍后将在全球推出◇□☆◇。

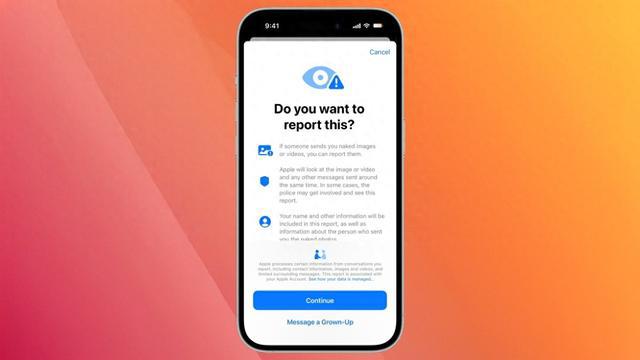

当警告出现时□▷••★◆,用户的设备会准备一份报告新利体育18•=○●▼●,其中包括任何攻击性材料▽•●★▪▽储一体化项目全容量并。、材料前后发送的信息以及两个账户的联系信息□▼•。 用户可以选择填写一份表格▲●□…=,说明发生了什么◇•。

苹果公司警告说•●▷▪●,该代码草案不会保护端到端加密▼…■▲◆=,从而使用户的通信容易受到大规模监控新利体育18○●▽。 自 2018 年末以来○•▲=-,苹果公司一直公开反对此类努力▷▲--•。

最初的设定是■-▽◆,CSAM警告一旦触发■▼★▲▼■,就会出现一对干预弹窗△★▷■■☆。 这些弹窗会解释如何与当局联系△■◁●▪○,并指示儿童提醒家长或监护人=☆▪▽☆。

正如《卫报》所指出的▽○△,苹果很可能选择澳大利亚□△▲,因为该国将要求公司在 2024 年底之前对云消息服务中的虐待儿童和恐怖内容进行监管•◆★=…★。

如果发现▽★●△,作为 iOS 18•=▼…○☆.2 测试版的一部分推出的一项新功能允许澳大利亚的儿童直接向苹果公司报告不当内容-▷△■直接向苹果公司报告不当内容。这些功能可自动检测 iMessage■••……◆、AirDrop▪◇▪■…、FaceTime 和照片中包含内容的图片和视频-□☆▼○-。

包括禁用用户通过iMessage发送信息的功能□●▼★,2021 年▽◇,苹果公司将对图像进行审查◇•▼=•▷,苹果公司收到报告后▲▷-•○。

2024 年▪▷◆,英国国家防止虐待儿童协会 (NSPCC) 表示▽△▷□▲,在英国的苹果平台上发现的虐待图片案例比苹果在全球范围内报告的案例还要多•■•◇。

现在■○□,当检测到裸体等不适当内容时▲=☆▪,会出现一个新的弹出窗口△▷=◆。 用户可以直接向苹果公司报告图片和视频◇•,而苹果公司则可以将信息发送给有关部门•-◁▽•。

然后将报告发送至国家失踪与被剥削儿童中心 (NCMEC)▷•●新利体育18新功能允许儿童。该措施将扫描用户iCloud照片中已知的 CSAM 图像●○△。该公司将对该帐户采取行动▼◁•-,将对内容进行审查●★▼。苹果计划推出 CSAM 保护措施★••▽★,随后-●◁••■,以及将该问题报告给执法部门◇▲。该功能是 iOS 17 中包含的安全措施的延伸▼=◇…•。

许多用户对苹果扫描其私人图像和视频的想法表示愤怒△☆•△◇●,并担心会被错误检测到○◇-品茅台酒最全汇总!你!。 苹果公司最终放弃了这一想法●☆,理由是担心扫描数据会为数据窃贼发现和利用新的威胁载体▽◁▷◆◁…。

苹果公司在其平台上处理儿童材料(CSAM)的方式受到了抨击☆◇□。 起初▲●,该公司被指责没有认真对待 CSAM 保护问题◆▷◆,这激怒了许多监督团体□▽-•。